線形回帰とは:定義・最小二乗法・応用と評価の入門ガイド

初心者向け:線形回帰の基礎から最小二乗法、実務応用と評価指標まで図解でわかる入門ガイド

線形回帰は、従属変数と1つ以上の説明変数の間の関係を直線(あるいは説明変数の線形結合)で表す統計的手法です。これは、回帰分析の特殊なケースであり、モデル中の未知のパラメータが説明変数に対して線形に現れることが特徴です。

線形回帰が広く研究されている理由は主に次の2点です。第一に、モデルがパラメータに線形に依存すると扱いやすく、解析や推定が容易になること。第二に、得られた推定量(係数など)の統計的性質(期待値、分散、分布近似など)を理論的に導きやすいことです。これらにより、解釈や検定、予測の信頼区間の計算などが体系的に行えます。

線形回帰の実用的な用途は多岐にわたり、大きく分けて次の2つの目的で使われます:

- 予測(予測モデルの構築): 観測データに基づいてモデルを適合し、新しい説明変数の値から従属変数の値を予測するために使用します。たとえば、売上高の予測や気温の予測などが該当します。

- 因果推論・関係の解析(説明): 目的変数 y と多数の説明変数 X1, …, Xp が与えられると、線形回帰は y と各 Xj の関係の強さを定量化し、どの変数が y と統計的に関連しているか、どの説明変数が冗長か(他と強く相関しているか)を判断するために使えます。

フィッティングの考え方(最小二乗法と他の手法)

典型的な線形回帰モデルは、各観測 i に対して

yi = β0 + β1xi1 + … + βpxip + εi

の形を取り、εi は誤差項(残差)です。モデルを「データにフィットさせる」とは、観測値とモデルによる予測値の差(残差)の総和をできるだけ小さくする係数 β を求めることを意味します。

最も一般的な方法は、残差の二乗和を最小化する最小2乗法(OLS: Ordinary Least Squares)です。OLS によって得られる推定量は、標準的な仮定(誤差の独立性・平均ゼロ・等分散・正規性など)が成り立てば良い性質(不偏性、最小分散性など)を持ちます。

ただし、フィッティングには他のアプローチもあります。ノイズや外れ値に対して頑健な推定を行うために、残差の絶対値和を最小化する方法(最小絶対偏差回帰やロバスト回帰)や、ノルムに基づく別の目的関数を用いる方法があります。さらに、過学習や共線性を抑えるために、最小二乗の損失関数にペナルティを加えるリッジ回帰(L2ペナルティ)やラッソ(L1ペナルティ)、Elastic Net といった正則化手法が使われます。

係数の推定と計算

行列表示を用いると、デザイン行列 X(列が説明変数)、目的変数ベクトル y に対して、OLS の閉形式解は

β̂ = (X'X)^{-1} X'y(ただし X'X が可逆である場合)

で与えられます。実務では数値的不安定性や次元の問題があるため、特異値分解(SVD)やQR 分解を使って安定に計算することが多いです。

モデル評価と診断

- 決定係数 R² / 調整済み R²:モデルがデータのばらつきをどれだけ説明できるかを示します。説明変数を増やすと R² は増加するため、説明変数の数を考慮する調整済み R² も重要です。

- 係数の標準誤差と検定:各係数の t 検定や p 値により、その説明変数が統計的に有意かどうかを評価します。

- 残差解析:残差プロット(残差対予測値、残差の自己相関、QQプロットなど)により、線形性・等分散性・誤差の正規性・独立性の仮定が満たされているかを確認します。

- 影響度と外れ値の検査:Cook の距離、レバレッジ、外れ値の検出により、推定に大きな影響を与える観測を特定します。

- 多重共線性の診断:説明変数同士が高い相関を持つと係数の分散が大きくなります。分散拡大因子(VIF)で評価し、必要に応じて変数選択や正則化を行います。

仮定と注意点

線形回帰を適用する際には、少なくとも以下の仮定が問題ないか確認することが重要です:

- モデルが線形の形で妥当である(説明変数と目的変数の関係が(変換を含めて)線形で表現できる)

- 誤差項が独立で平均ゼロ、等分散である(ホモスケダスティシティ)

- 説明変数間に完全な共線性がない(X'X が特異でない)

- 推定や検定のために誤差項が正規分布に従う(特に小標本の場合)

これらが破られると、推定量の分散や検定結果が信頼できなくなるため、適切な変換、外れ値処理、ロバスト推定、あるいは別のモデル(一般化線形モデルなど)への切り替えを検討します。

応用と拡張

線形回帰は経済学、社会科学、自然科学、機械学習など多くの分野で基礎的な手法として使われます。代表的な拡張としては:

- 多項式回帰(説明変数の高次項を加え非線形関係を線形形式で表現)

- 正則化(リッジ回帰、ラッソ、Elastic Net)による過学習抑制

- 一般化線形モデル(GLM):誤差分布やリンク関数を変えて二項やポアソンなどへの対応

- 混合効果モデル:階層構造やランダム効果を扱う場合

実務上のアドバイス(まとめ)

- 目的(予測か説明か)を明確にし、それに合った評価指標でモデルを選ぶ。

- 説明変数のスケーリングやダミー変数化、相互作用項の検討を行う。

- 残差診断を怠らず、仮定違反があれば対処(変換、ロバスト法、別モデル)する。

- 相関は因果を示さない。因果推論を行う場合は実験設計や外生変数の利用を検討する。

最小二乗は強力で広く使われますが、「最小二乗」と「線形モデル」が同義ではない点に注意してください。最小二乗法は線形モデル以外(例えば非線形モデルのパラメータ推定)にも用いることができますし、線形回帰でも最小二乗以外の手法(ロバスト回帰や正則化など)を用いることが実務的には多々あります。

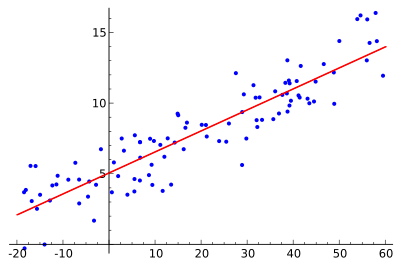

アイデアは、赤い曲線を見つけることであり、青い点は実際のサンプルです。線形回帰では、すべての点を1本の直線で結ぶことができます。この例では、赤線と各サンプル点の間の距離の二乗が最小化される単純な線形回帰を使用しています。

使用方法

経済学

線形回帰は、経済学の主要な分析ツールである。例えば、消費支出、固定投資支出、在庫投資、その国の輸出購入、輸入支出、流動資産保有需要、労働需要、労働供給などを推測するために用いられる。

質問と回答

Q:線形回帰とは何ですか?

A: 線形回帰は、数学を使って、他のものが変化したときに何かがどのように変化するかを見る方法です。従属変数と1つ以上の説明変数を用いて、「回帰線」と呼ばれる直線を作成します。

Q: 線形回帰の利点は何ですか?

A: 未知のパラメータに線形的に依存するモデルは,そのパラメータに非線形的に関連するモデルよりも適合しやすい.さらに,得られる推定量の統計的性質が決定しやすい.

Q: 線形回帰の実用的な使用方法は何ですか?

A: 線形回帰は,予測,予想,削減を行うために,観察された値(データ)に予測モデルを適合させるために使用できる.また、変数間の関係の強さを定量化し、別の変数に関する冗長な情報を含むデータのサブセットを識別するために使用することもできます。

Q: 線形回帰モデルは、どのように誤差を最小化しようとするのですか?

A: 線形回帰モデルは,直線とデータ点の間の垂直距離(残差)をできるだけ小さくしようとする.これは,残差の2乗和(最小2乗),他の規範における適合の欠如(最小絶対偏差),または最小2乗損失関数の罰則付きバージョン(リッジ回帰)のいずれかを最小化することによって行われる.

Q: 線形回帰モデルが最小二乗法に基づかないことは可能ですか?

A: はい、線形回帰モデルが最小二乗法に基づくのではなく、他の規範における適合度の欠如を最小化する方法(最小絶対偏差)や最小二乗損失関数のペナルティ版を最小化する方法(リッジ回帰)などを使用することは、可能です。

Q:「線形モデル」と「最小二乗法」は同義語ですか?

A: いいえ、同義語ではありません。線形モデル」は直線を使うことを意味し、「最小二乗」は直線とデータ点の間の垂直距離を最小にすることによって誤差を最小にしようとすることを意味します。

百科事典を検索する