最小二乗法(OLS)とは?線形回帰の推定原理と計算式

最小二乗法(OLS)の原理と計算式を図解でわかりやすく解説。線形回帰の推定手順や導出、実例で理解する入門ガイド。

Ordinary least squares または Linear least squares は、統計学において未知のパラメータを推定する方法である。線形回帰で使用される代表的な手法で、観察された応答とモデルが予測する応答との間の二乗誤差和を最小にすることを目的とする。差(残差)の二乗和が小さいほど、モデルがデータに良く適合していると見なされる。通常の最小二乗法は一般に最小二乗法と呼ばれる手法の特殊なケースであり、得られる推定量は簡潔な式で表される。

基本的な考え方

観測値を (y1, …, yn)、説明変数(特徴量)を行列 X、未知の係数ベクトルを β とすると、線形回帰モデルは一般に次のように書ける。

y = Xβ + ε

ここで ε は誤差ベクトル(平均ゼロ、分散 σ² の独立同分布が仮定されることが多い)である。OLS は残差の二乗和 S(β) = Σi (yi − xi'β)² を最小化する β を求める手法である。

行列表記による解(正規方程式)

目的関数を β で偏微分してゼロにすることで正規方程式が得られる。解は次のようになる(X' は X の転置)。

β̂ = (X'X)^{-1} X' y

ただし X'X が可逆(列が線形独立である=フルランク)であることが必要である。数値計算上は、QR 分解や特異値分解(SVD)を用いて解くと安定である。

単回帰(説明のための具体式)

説明変数が1つ(x)の場合、切片を β0、傾きを β1 とすると推定式は次の通りである。

β1̂ = Σi (xi − x̄)(yi − ȳ) / Σi (xi − x̄)²

β0̂ = ȳ − β1̂ x̄

ここで x̄, ȳ はそれぞれの標本平均である。

推定量の性質

- 不偏性:誤差の期待値が零であり説明変数が確定である(または誤差と無相関)なら、β̂ は不偏推定量である。

- 分散:Var(β̂) = σ² (X'X)^{-1}。σ² は誤差分散で、通常は残差平方和を自由度で割った値で推定する。

- Gauss–Markov 定理:誤差が等分散かつ相関がないという条件の下で、OLS 推定量は線形不偏推定量の中で最小分散(BLUE:Best Linear Unbiased Estimator)である。

- 正規性が仮定できる場合:誤差が正規分布に従うと仮定すると、OLS は最尤推定量(MLE)にもなり、t 検定や F 検定による推論が可能になる。

モデルの評価指標と残差解析

- 残差:e = y − Xβ̂。残差のプロットで非線形性、外れ値、異分散、自己相関などをチェックする。

- 決定係数 R²:R² = 1 − RSS/TSS(RSS:残差平方和、TSS:全平方和)。モデルがデータの分散をどれだけ説明しているかを示す。ただし説明変数を増やすと常に増加するため、調整済み R² を使うことが多い。

- 調整済み R²:自由度を考慮してモデル比較を行う指標。

現実の問題と対処法

- 多重共線性:説明変数間の高い相関により X'X がほとんど特異になり、係数の分散が大きくなる。対処法:変数削減、主成分回帰、リッジ回帰など。

- 異分散性:誤差の分散が一定でない場合、標準誤差の推定が歪む。対処法:重み付き最小二乗(WLS)、ロバスト標準誤差(White 順序)など。

- 自己相関:時系列データで残差が相関を持つ場合には推定量の効率が低下し検定が誤る。対処法:自己回帰項の導入、一般化最小二乗(GLS)など。

- 外れ値と影響点:外れ値は推定結果に大きく影響する。対処法:診断統計量(クックの距離等)、ロバスト回帰。

計算上の注意

- 数値的安定性の観点からは、正規方程式を直接解くよりも QR 分解や SVD を用いるのが望ましい。

- 大規模データやスパース行列の場合は専用のアルゴリズム(確率的勾配降下など)を用いることが多い。

まとめ

最小二乗法(OLS)は線形回帰における基本かつ強力な推定手法であり、解析・推論の基礎となる。ただしその有効性はモデル仮定(線形性、誤差の無相関・等分散・平均零など)に依存するため、残差診断や代替手法の検討が重要である。適切な前処理、診断、必要に応じたロバスト化や正則化を組み合わせることで、現実のデータに対してより信頼性の高い推定が可能になる。

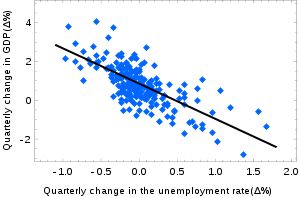

マクロ経済学におけるオクンの法則とは、ある経済においてGDP成長率は失業率の変化に直線的に依存するはずだというものである。ここでは、この法則を記述する回帰直線を作成するために、通常の最小二乗法が用いられている。観測値は青で、期待値は黒で示されている。

百科事典を検索する